本文是我的视频《物理机 直通还是半虚拟化?Openwrt网卡性能及资源占用测试》内容的图文展示及补充说明

B站:https://www.bilibili.com/video/BV1cy4y1L7FF

油管:https://youtu.be/dKfEKOJKjZs

这个视频确实拖了非常久,因为在视频制作的过程中遇到很多问题,而我又想尽量达到一个比较生动美观的效果。

事实上,期间还有别的话题录好素材写好文案,最终却放弃了…

过了这么久,这些测试数据发生变化也是难免的,要不要重新测试呢?ヾ(。 ̄□ ̄)ツ゜゜゜按我那样的测试方法是非常耗时的…

我想表达的核心不是一个准确的数字,而是不要轻易相信别人说怎么好,自己去试试,可能会有很多新的发现。

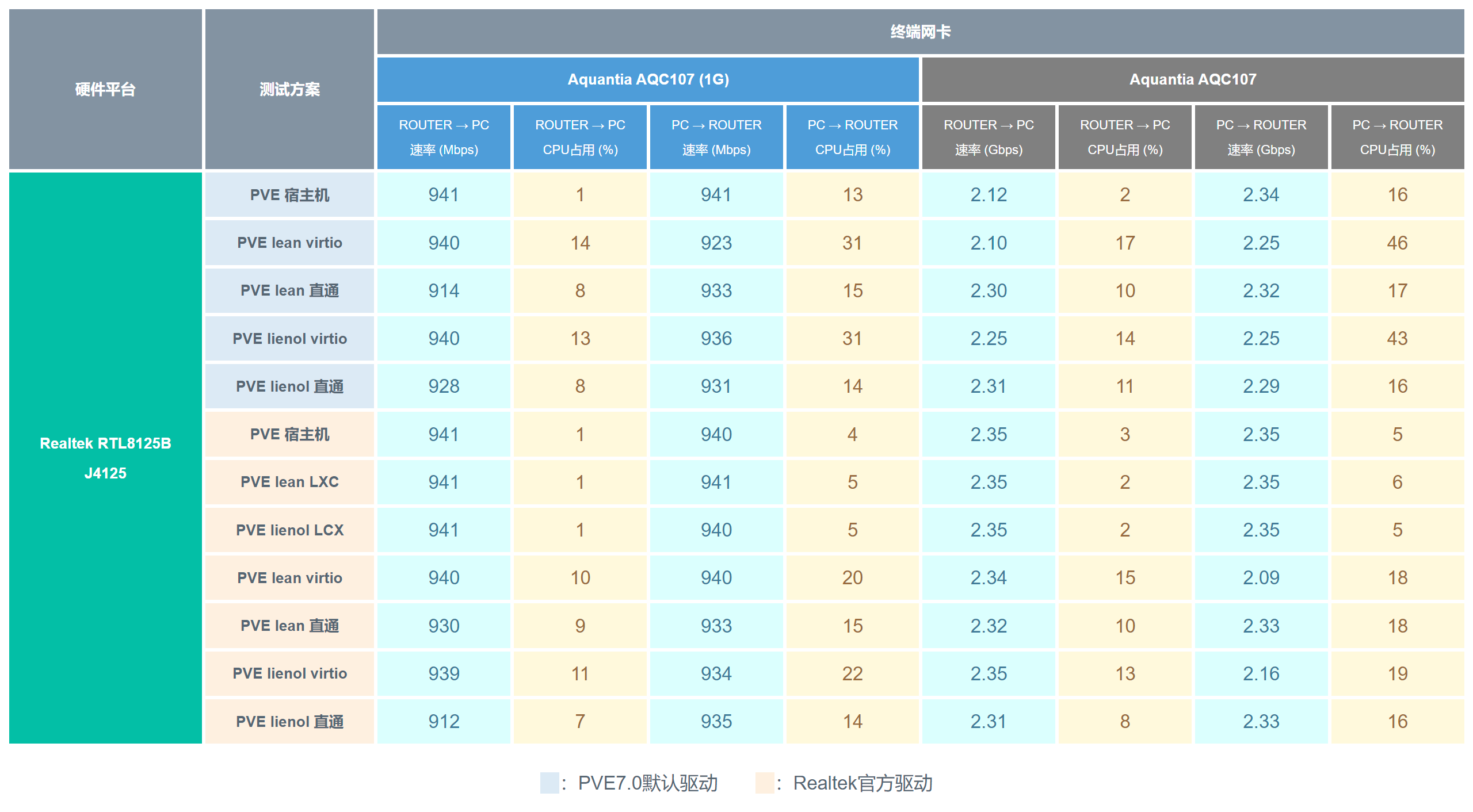

关于视频中的几款网卡,主要有变化的是RTL8125B,后文增加了PVE7.0自带RTL8125B驱动和官方新版驱动在PVE下的测试数据。

而RTL8111F如果使用新版PVE并安装官方驱动,虽然一般能跑满,但是资源占用会更高一些。

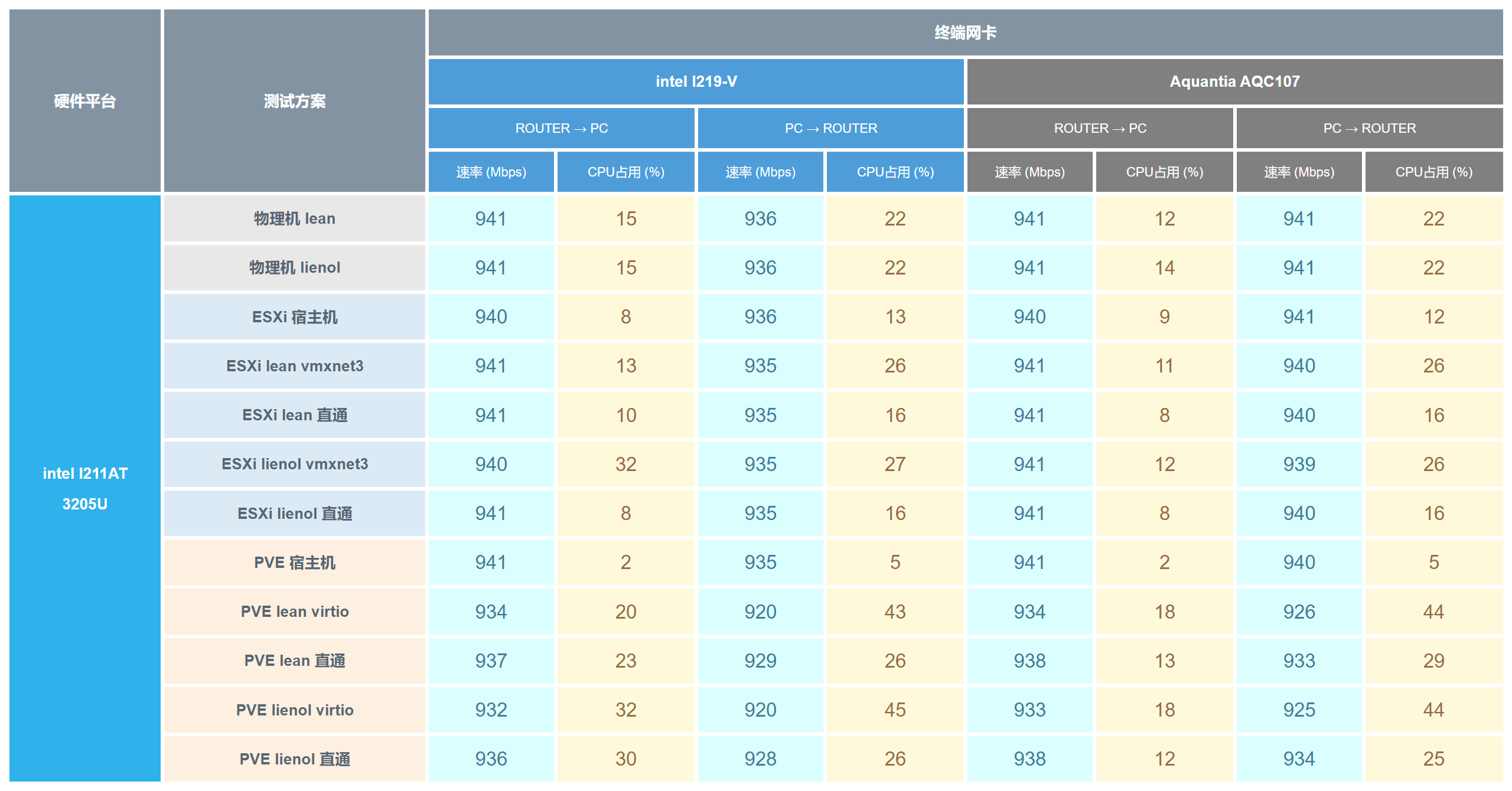

intel i211-AT

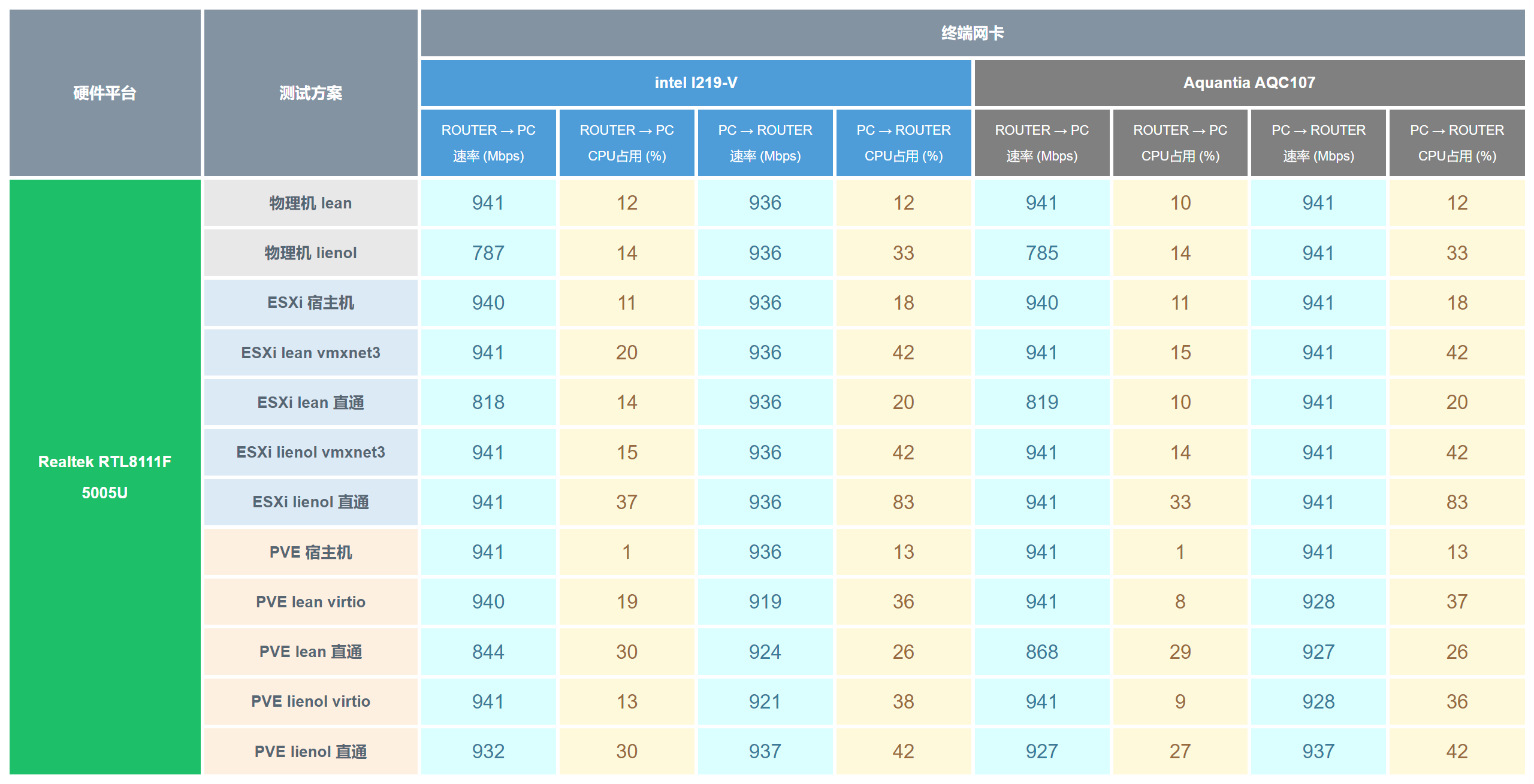

Realtek RTL8111F

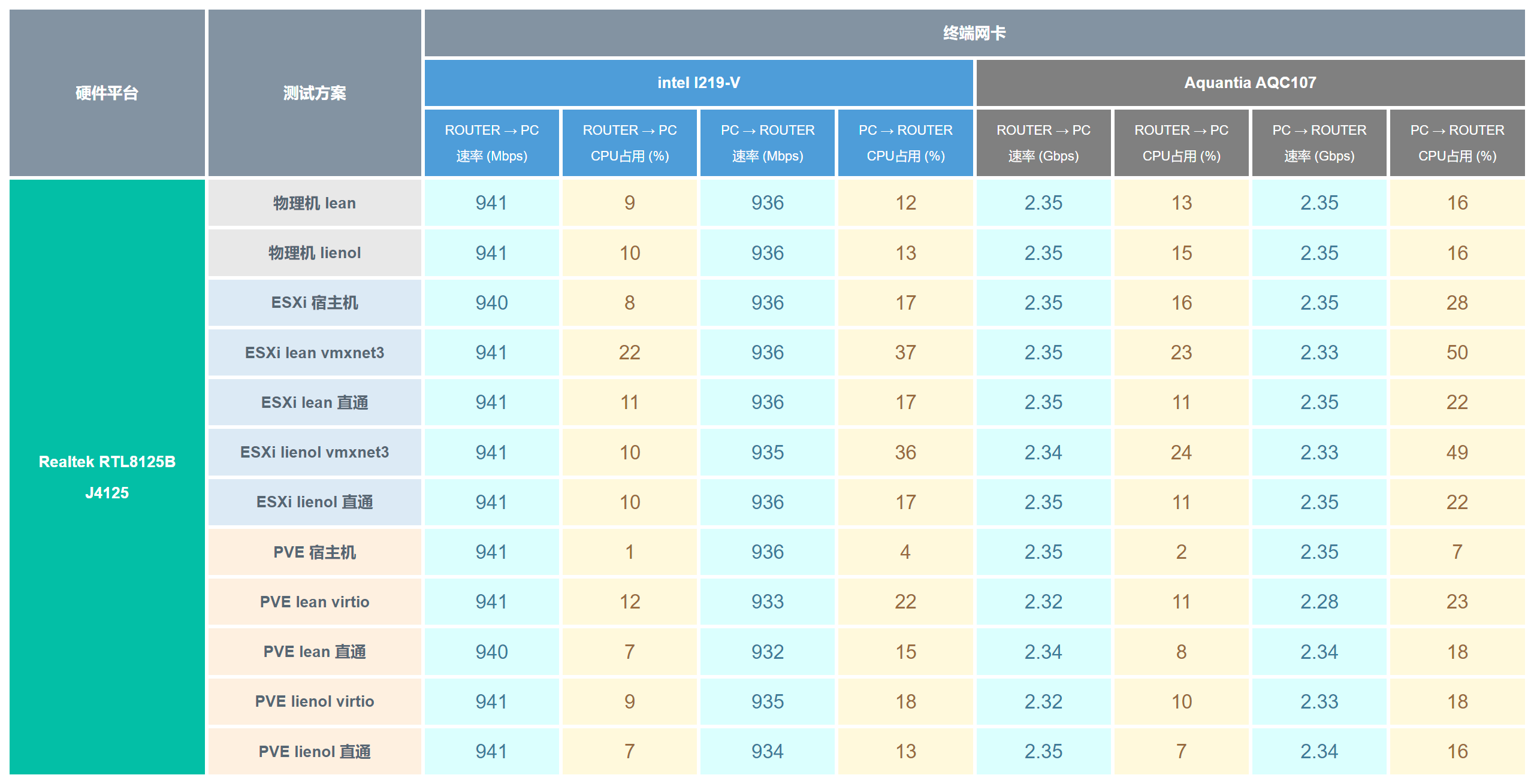

Realtek RTL8125B

Realtek RTL8125B(更新)

目前来看PVE7.0自带的RTL8125B驱动并不是很理想。

这次测试电脑没有保持完全待机状态,有一些波动也是正常的,按理说PVE的网卡驱动不会对直通网卡有什么影响。

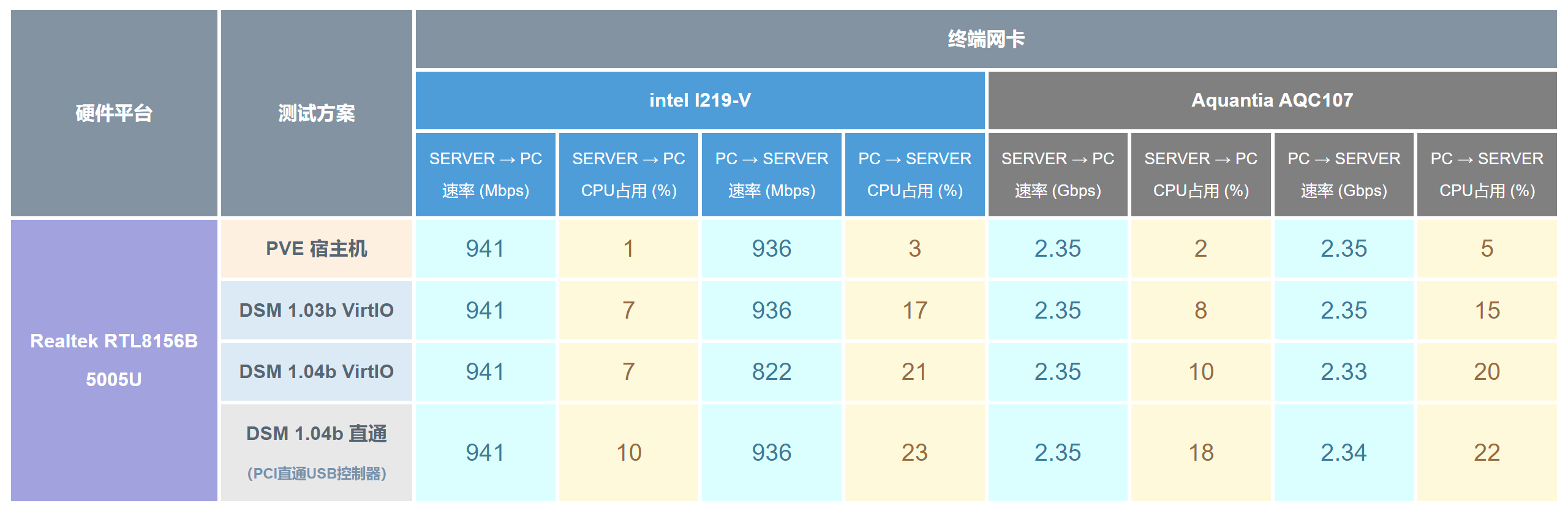

Realtek RTL8156B

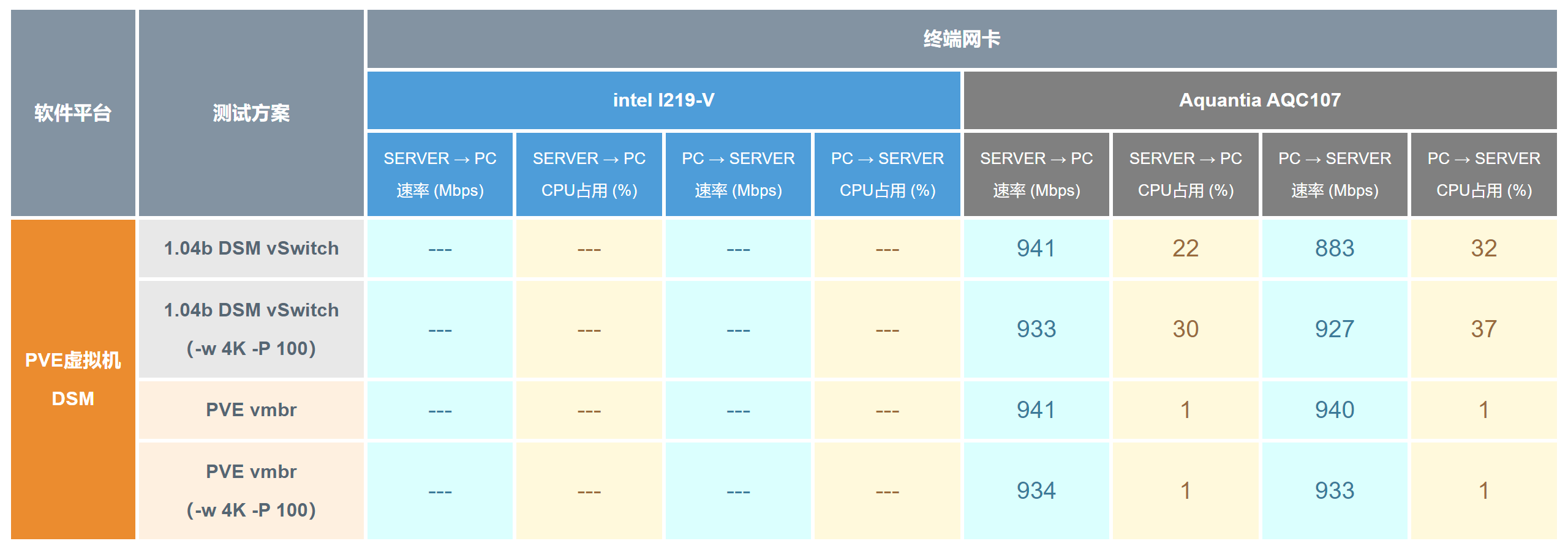

PVE虚拟机DSM软交换

为什么PVE软交换测试资源占用这么低?

并没有搞错,原因很简单,虚拟网桥软交换方案并不通过虚拟机,半虚拟化的效率已与其无关。更重要的是iperf软件并未运行在PVE机器上,而是运行在测试电脑和服务端机器。

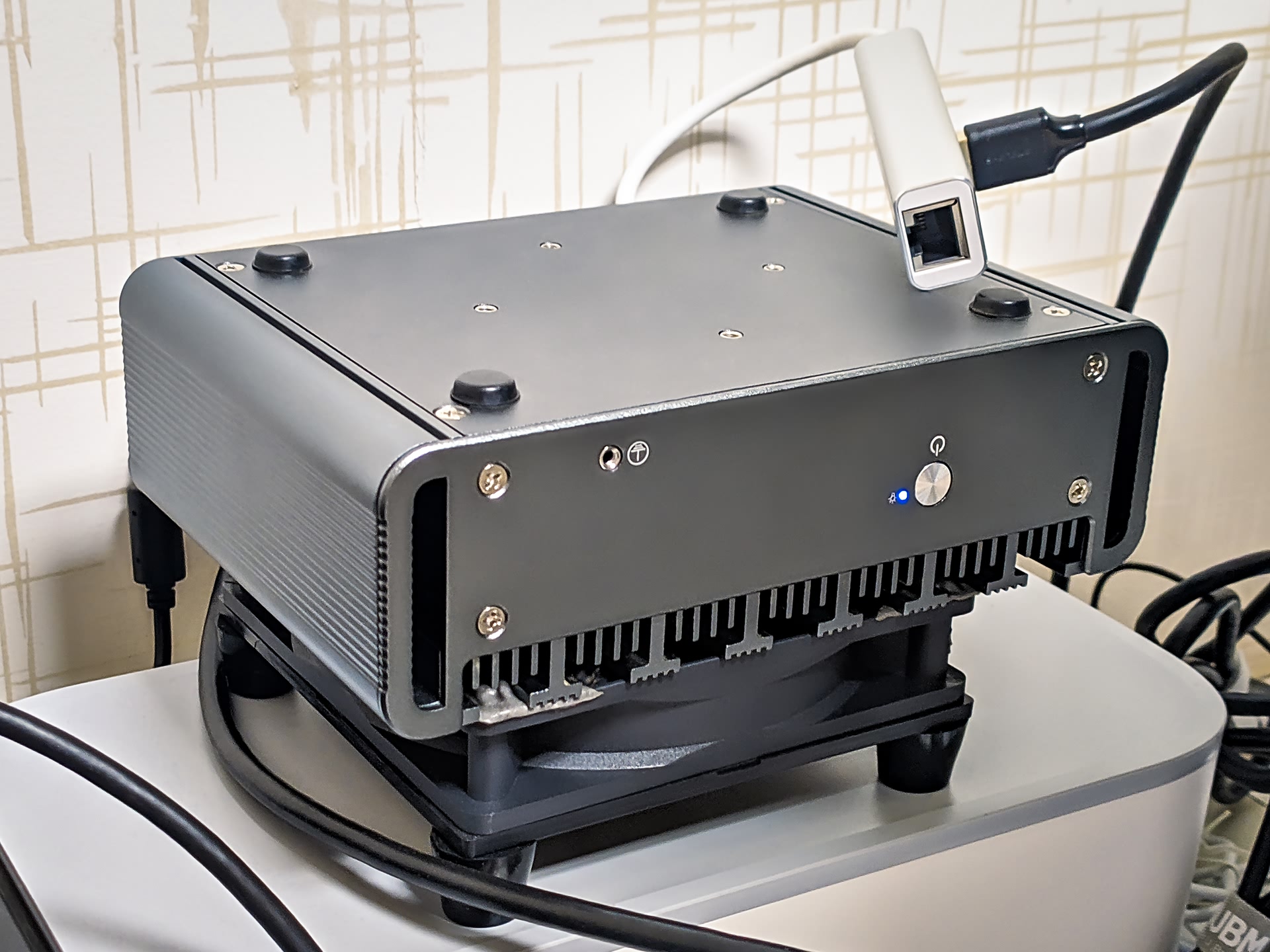

关于散热

后来买个两个这样的USB风扇,价格便宜,噪音也很小,比较推荐。

对于其他虚拟机平台,我确实接触的很少。Windows Server下也可以实现软桥接,但大概试了下速度比较拉胯。还有Windows平台的VMware,默认网卡模型就不用说了,使用Vmxnet3相比ESXi下也相差甚远。至于Unraid,没有用过,个人感觉大体上和PVE差不多,而我目前的机器是黑群晖虚拟机直通SATA控制器,Windows虚拟机直通核显,这种情况下PVE相对来说还是更方便灵活一些。

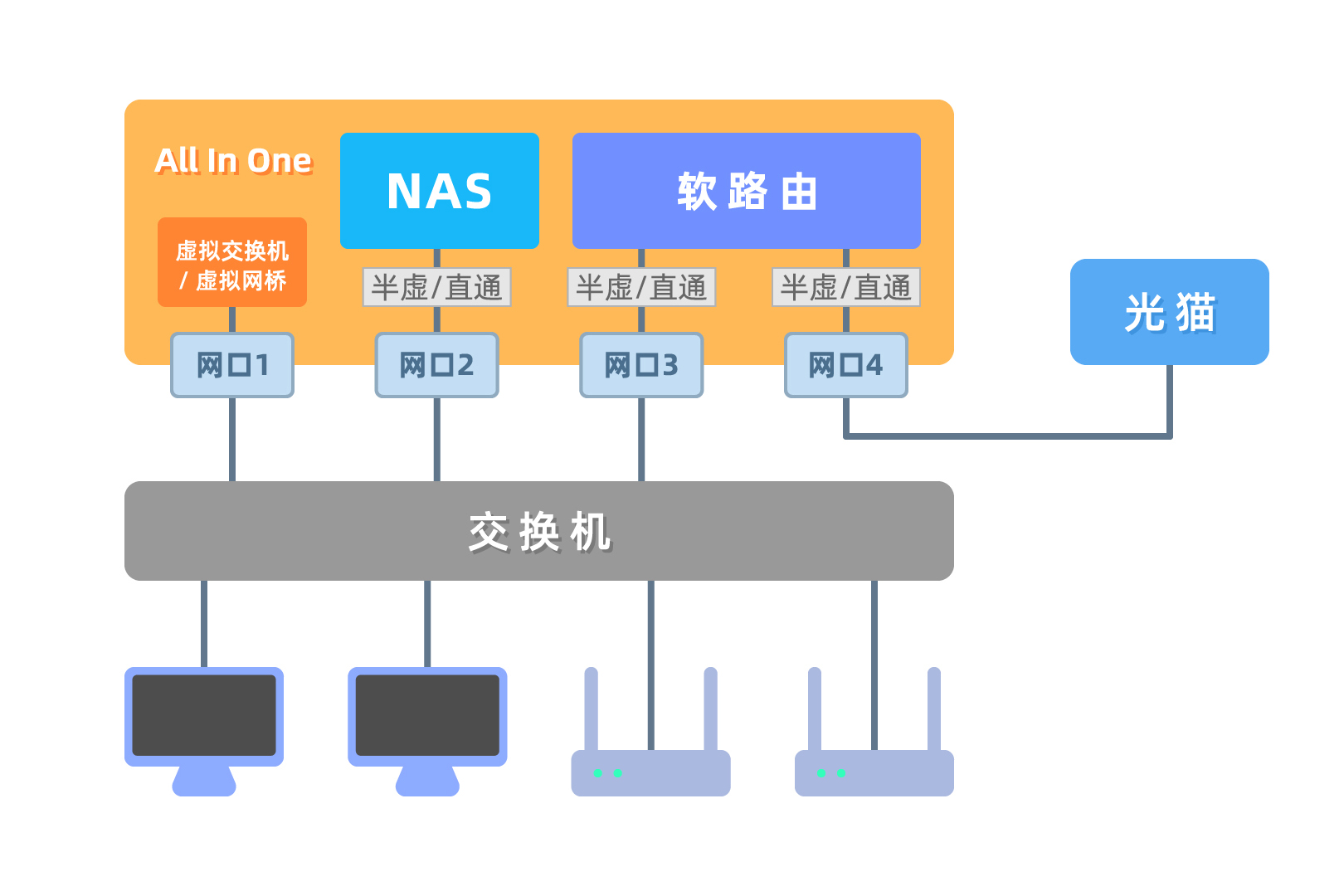

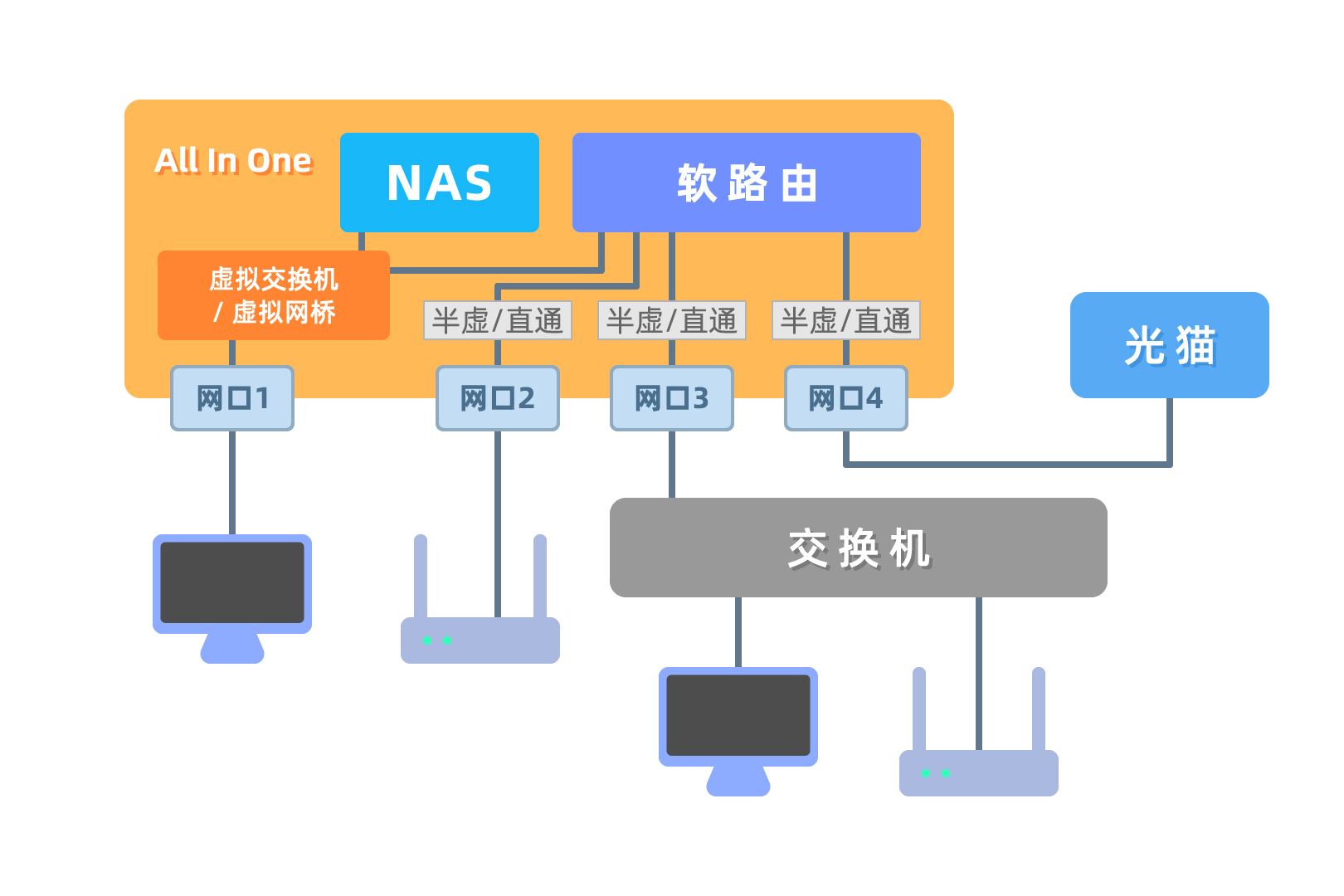

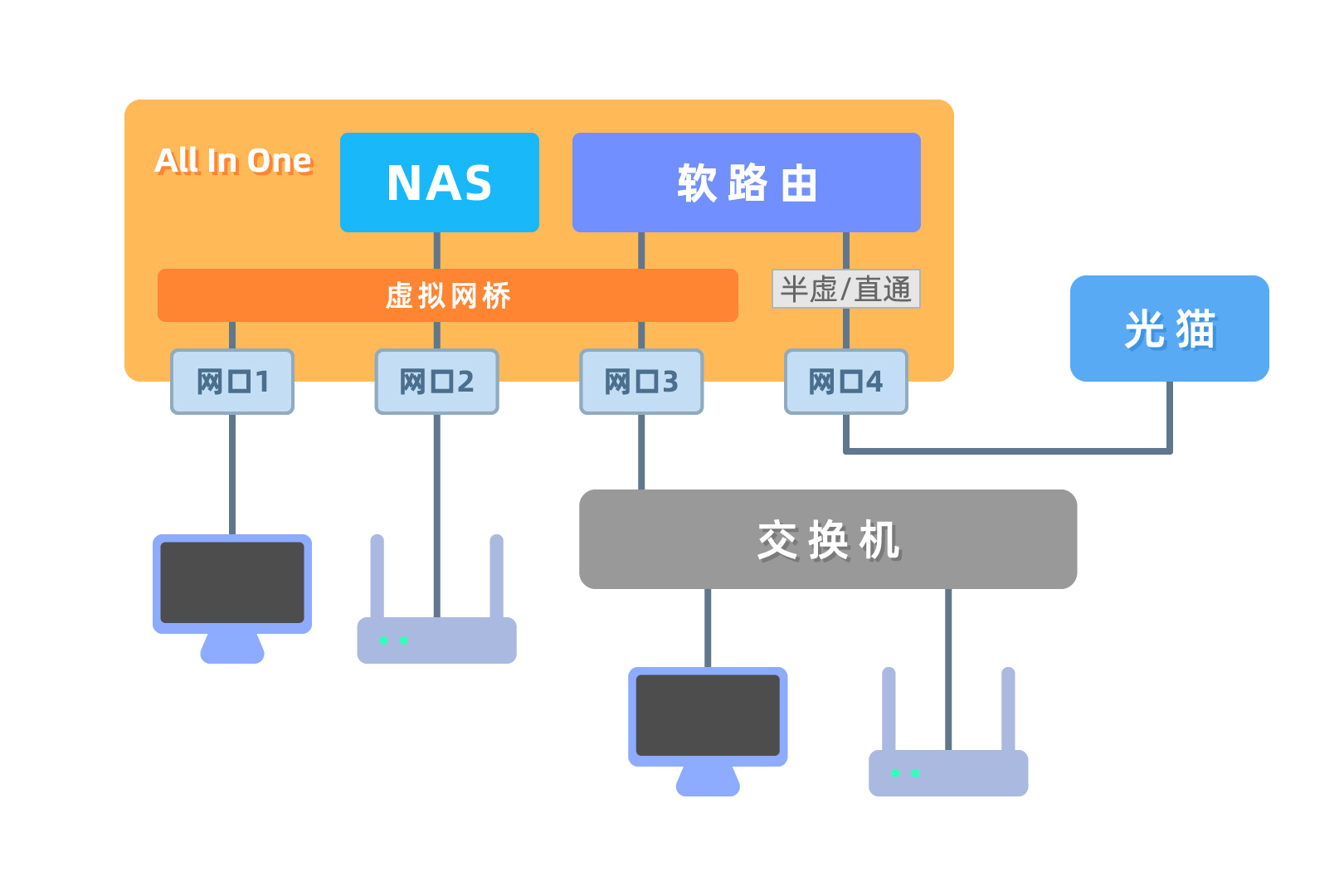

网络拓扑方案

可能对于软路由来说,测试不同方案网卡性能就够了,但如果是加入了NAS系统后的All in one主机,这个问题就变得复杂了起来。或是因为一些其他条件限制,不能只考虑网卡效率。

这里我提出一个问题,暂不做深入探讨,大家可以想一下。

假设一个4块硬盘的主机组Raid5,磁盘速度400MB/s左右,要尽可能高效,并且要让多个终端同时访问NAS数据时带宽尽可能大,以下3种方案,你会选哪一种?

1. 网卡均使用直通,通过交换机来进行连接

2. 直通和半虚拟化混合??通过软路由虚拟机来桥接,一句话有点难说清楚

3. 全部使用半虚拟化,通过虚拟网桥连接(这种方案ESXi貌似实现不了)

这里面存在着很多变数,嗯…

这个视频录制素材到出片,真的隔的太久太久。

前期为了录音折腾了好久,只有抽空躲在车里断断续续地录,而且试图纠正自己普通话发音,对于一个从不说翘舌音的武汉人来讲,真的各种别扭各种难。前后重录了几次,但是声音太闷,用AU各种处理,效果还是不好,所以无奈最终使用了机器配音。

为了填补视频中没有素材可用的部分,对着镜头说话是不现实的,毕竟说都话不清楚,于是自己画图制作了Live2D模型,不是美术相关专业,这个也是比较困难的。

最后,想要把视频做的美观生动一些,又花时间学习了AE,当然我现在的AE水平顶多算刚入门。

期间还遇到很多其他问题就不细说了。 不过花费了这么多时间,之后要做视频会相对容易一些。

5 comments

新手完全不懂直通和虚拟网桥的逻辑,因为不会MCX342不会弄ikuai的驱动,瞎蒙在PVE的vmbr0上多输了几个网口,是否相当于作者的第三种模式了

是的

我得方案是pve下kvm下全部用sr-iov直通网卡,op的lan也是通过sr-iov直通,wan再直通光猫,这样不管是交换机还是kvm都可以利用网卡内部交换,就不用消耗cpu了。

不消耗CPU是不可能的,物理机也会消耗CPU,只是会比VirtIO低一点。sr-iov必须要有物理交换机,和vmbr的差异还是非常大的,而相比方案一,大概也就可能做到省一个万兆网口的效果。另外我个人测试sr-iov跑满的情况下会造成机器短暂卡死。

如此看来,KVM的效率也不是很差。除了一些特殊情况,LXC是更优解,比如显卡直通。。。